はじめに

CPU(中央処理装置)は、コンピュータの「脳」とも呼ばれる最も重要な部品であり、その進化はコンピュータの性能向上と共に歩んできました。この記事では、CPUの発展の歴史を追い、その技術革新が現代のコンピューティングにどのような影響を与えたのかを解説します。

CPUの誕生と初期の発展

ENIACとUNIVACの時代

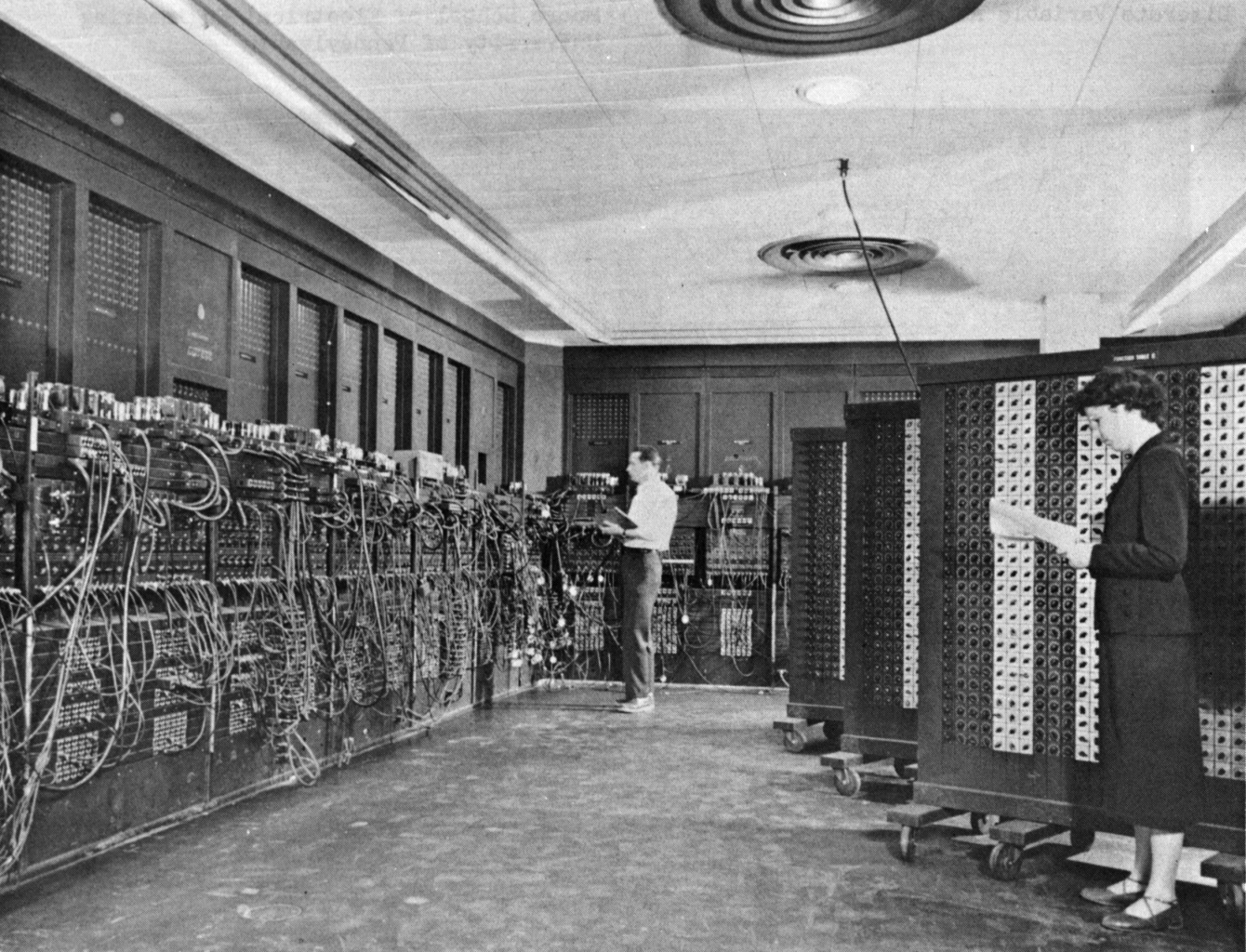

コンピュータの歴史を語る上で、初期の計算機器であるENIAC(Electronic Numerical Integrator and Computer)を避けて通ることはできません。ENIACは、1946年にアメリカ陸軍の支援のもとで開発された、世界初の完全電子式計算機です。このマシンは、17,000本以上の真空管を使用し、1,500平方フィートの広さを占める巨大なものでした。ENIACは、当初は弾道計算に使用されましたが、その後も科学技術分野で広く利用されました。

ENIACの後継機として開発されたのがUNIVAC(Universal Automatic Computer)で、1951年に公開されました。UNIVACは、商業利用を目的とした世界初のコンピュータであり、そのCPU(中央処理装置)は、ENIACに比べてはるかにコンパクトで効率的でした。UNIVACは、アメリカ合衆国の国勢調査局によって採用され、データ処理の分野に革命をもたらしました。

最初の商業用マイクロプロセッサIntel 4004の登場

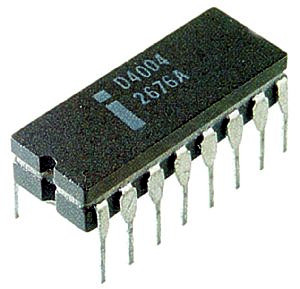

1971年にIntelが開発したIntel 4004は、世界初の商業用マイクロプロセッサとして、コンピュータの歴史に新たなページを刻みました。このプロセッサは、たった4ビットの処理能力しか持たないものでしたが、それまで巨大なコンピュータで行っていた演算を、手のひらサイズのチップ上で行うことを可能にしました。Intel 4004は、コンピュータの小型化と普及の始まりを象徴するものであり、後に登場するマイクロコンピュータの基礎となりました。

このプロセッサは、4ビットのデータを扱い、命令セットはわずか46種類という非常に簡素なものでしたが、それでも当時の技術としては革新的でした。また、Intel 4004は「モノリシック・プロセッサ」として、1枚のシリコン基板上に全ての機能を集約した最初のプロセッサであり、この設計思想は現代のプロセッサにも引き継がれています

16ビットから32ビットへの進化

1970年代から1980年代にかけて、マイクロプロセッサの進化は飛躍的に進みました。特に、Intelは次々と革新的なプロセッサを開発し、1978年に登場したIntel 8086は、その後のPC市場における標準アーキテクチャとなるx86アーキテクチャを採用していました。8086は16ビットプロセッサであり、メモリアドレス空間が1MBに拡大し、当時としては大容量のデータを処理することが可能になりました。

その後、1985年にIntelが発表したIntel 80386は、32ビットアーキテクチャを採用し、マルチタスク処理が可能な環境を提供しました。80386は、275,000個のトランジスタを搭載し、複雑な処理を効率的にこなすことができました。この時期、モトローラの68000シリーズも非常に人気があり、特にAppleやAtari、Amigaなどのコンピュータに搭載されていました。モトローラのプロセッサは、CISC(Complex Instruction Set Computer)アーキテクチャを採用しており、インストラクションの多様性と処理能力が評価されました。

RISCとCISCの戦い

RISCアーキテクチャの登場と普及

1980年代に入り、CPUの設計思想が大きく2つの流れに分かれました。その1つがRISC(Reduced Instruction Set Computer)アーキテクチャです。RISCは、UCバークレー大学で研究が進められた結果、1980年に提唱されたコンセプトで、複雑な命令セットを減らし、シンプルで効率的な命令セットを持つプロセッサ設計です。RISCの基本的なアイデアは、「ハードウェアの複雑さを抑え、命令の処理を単純化することで、パフォーマンスの向上を図る」というものです。

最初の商用RISCプロセッサとして、1985年にMIPS R2000が登場しました。MIPS(Microprocessor without Interlocked Pipeline Stages)は、主に科学技術計算やグラフィック処理に強いプロセッサとして評価され、Silicon Graphics(SGI)などの企業に採用されました。その後、SPARC(Scalable Processor Architecture)が1987年にSun Microsystemsによって導入され、RISCアーキテクチャの代表例となりました。また、1990年代にはAppleやIBM、Motorolaが協力して開発したPowerPCプロセッサもRISCアーキテクチャを採用し、AppleのMacintoshやIBMのワークステーションで利用されました。

IntelとMotorolaによるCISCアーキテクチャの改良

一方、RISCとは対照的にCISC(Complex Instruction Set Computer)アーキテクチャは、複雑な命令セットを提供する設計方針を持っていました。CISCは、1つの命令で複数の操作を行うことで、プログラムの命令数を削減し、プログラミングを容易にするという考えに基づいています。このアーキテクチャの主な代表例が、Intelのx86シリーズです。

1980年代に登場したIntel 8086やIntel 80286は、CISCアーキテクチャの成功例であり、特に8086はIBMのPCに採用され、x86アーキテクチャの標準化を推進しました。CISCアーキテクチャは、複雑な命令セットを備えているため、特定のタスクを効率的に処理する能力に優れていました。これに対して、Motorolaは68000シリーズでCISCの利点を活かし、Appleの初代MacintoshやAtari、Amigaなどに搭載され、多くのコンピュータメーカーに支持されました。

1980年代のPC市場での競争

1980年代後半から1990年代にかけて、RISCとCISCの両アーキテクチャの競争は激化しました。特にPC市場において、Intelのx86アーキテクチャは圧倒的なシェアを誇り、CISCアーキテクチャを採用したプロセッサが主流となりました。一方で、RISCアーキテクチャはワークステーションやサーバー、エンタープライズ向けのシステムで広く利用されました。Sun MicrosystemsのSPARCや、IBMのPowerPCなどは、性能と効率性を武器にエンタープライズ市場でのシェアを拡大しました。

しかし、RISCとCISCの境界は徐々に曖昧になっていきました。例えば、CISCアーキテクチャであるIntelのプロセッサにも、パイプライン処理や分岐予測などのRISC的な概念が取り入れられるようになり、設計の融合が進んでいきました。これは、RISCとCISCの両方がそれぞれの長所を取り入れることで、性能を最大限に引き出そうとする流れが生まれたことを示しています。

マルチコア時代の到来

IntelのPentiumシリーズとAMDのAthlonの競争

1990年代後半から2000年代初頭にかけて、PC市場ではIntelとAMDの熾烈な競争が展開されました。Intelは1993年に登場したPentiumシリーズでパフォーマンスリーダーシップを確立し、その後も継続的に改良を重ねました。Pentiumプロセッサはスーパースカラーアーキテクチャを採用しており、1クロックサイクルあたり複数の命令を処理できるため、パフォーマンスが大幅に向上しました。

一方、AMDは1999年に登場したAthlonプロセッサでIntelに強力な対抗馬を送り出しました。Athlonは、当時のIntelの主力製品であったPentium IIIに対抗し、パフォーマンスと価格の両面で非常に競争力のあるプロセッサでした。特に、AMDのAthlonは、Intelのプロセッサよりも高いクロック速度を実現し、消費者の注目を集めました。この結果、AMDは市場シェアを拡大し、PC愛好家やエンスージアストの間で人気を博しました。

メガヘルツ競争とその限界

2000年代初頭には、IntelとAMDの間でいわゆる「メガヘルツ競争」が激化しました。両社は、より高いクロック速度を持つCPUを市場に投入することで、性能を競い合いました。Intelは特にPentium 4プロセッサで3GHzを超えるクロック速度を実現しましたが、クロック速度を単純に上げるだけでは、実際のパフォーマンス向上が得られないことが明らかになってきました。クロック速度の上昇に伴う消費電力と発熱問題が深刻化し、パフォーマンス向上が頭打ちになるという課題が浮上しました。

特にIntelのNetBurstアーキテクチャは、深いパイプラインを持ち、クロック速度を上げることで性能を向上させる設計でしたが、31段にも及ぶパイプラインが原因で、予想以上に電力効率が悪くなり、発熱量も増大しました。この結果、IntelはPentium 4で10GHzを目指す計画を断念せざるを得なくなりました。

一方、AMDはクロック速度に依存しないアーキテクチャの改良に注力し、Athlon 64プロセッサを2003年に発表しました。Athlon 64は、業界初の64ビットプロセッサであり、将来のオペレーティングシステムやソフトウェアに対応できる優れたパフォーマンスを提供しました。また、32ビット環境との互換性も維持しながら、効率的なパフォーマンスを実現したため、プロフェッショナルから家庭ユーザーまで広く支持されました。

マルチコアアーキテクチャの普及

クロック速度の限界に直面したCPU業界は、マルチコアアーキテクチャへの移行を進めました。単純にクロック速度を上げるのではなく、1つのチップに複数のコア(演算ユニット)を搭載することで、並列処理を実現し、全体的なパフォーマンスを向上させるという考えです。これにより、プロセッサはより効率的に複数のタスクを同時に処理できるようになりました。

Intelは2006年にCore 2 Duoプロセッサを発表し、これは同社初のデュアルコアCPUでした。Core 2 Duoは、従来のPentium 4に比べて、消費電力が大幅に削減され、同時にパフォーマンスが向上しました。このプロセッサは、複数のコアを持つことで、複数のプログラムを同時に実行するマルチタスク能力が向上し、家庭用PCからビジネス用途まで幅広く採用されました。

AMDもまた、2007年にPhenomシリーズでクアッドコアプロセッサを導入し、Intelに対抗しました。Phenomは、効率的な電力消費と優れたマルチタスク性能を提供し、エンタープライズ分野やゲーム市場で人気を博しました。マルチコア技術はその後も進化を続け、現代のCPUでは8コア、16コア、さらには64コアといったマルチコア設計が当たり前となり、高度な並列処理が求められるタスクに対応できるようになっています。

モバイル時代と省電力設計

モバイルコンピューティングの台頭

2000年代に入ると、デスクトップPCやサーバーだけでなく、ノートパソコンやスマートフォン、タブレットといったモバイルデバイスの普及が急速に進みました。これに伴い、CPU設計にも新たな要求が生まれました。従来のデスクトップ向けCPUは、性能を重視するあまり電力消費や発熱量が大きく、モバイルデバイスには適していませんでした。そのため、省電力で高効率なCPUが求められるようになり、モバイル向けに最適化されたプロセッサが登場しました。

Intelは2003年に登場したPentium Mプロセッサで、モバイルデバイス向けのCPU市場に進出しました。Pentium Mは、従来のPentiumシリーズよりも低消費電力で動作しながら、パフォーマンスを維持することができ、ノートパソコン向けに最適化されていました。これにより、バッテリー寿命が延び、モバイルユーザーにとって大きな利点となりました。

また、2008年には、さらに低電力なIntel Atomプロセッサが登場し、これによって小型デバイスやネットブック市場が拡大しました。Atomは、超低電圧で動作することから、携帯機器や組み込みシステムに最適とされ、ネットブックや一部のタブレットに採用されました。

IntelのPentium MとARMプロセッサの成功

モバイルデバイス向けCPUの市場で、Intelと並んで非常に大きな影響力を持ったのがARMアーキテクチャです。ARM(Advanced RISC Machines)は、元々イギリスのAcorn Computersによって開発され、後に独立した企業として現在のARM Holdingsが設立されました。ARMのプロセッサは、RISCアーキテクチャをベースに設計され、非常に高い電力効率とパフォーマンスを誇ります。

ARMプロセッサは、その低消費電力性とシンプルな設計から、スマートフォンやタブレットなどのモバイルデバイスに広く採用されました。特に、AppleのiPhoneやiPadにはARMプロセッサが搭載されており、これがモバイル市場でのARMの成功を決定的なものとしました。さらに、GoogleのAndroid OSを搭載したスマートフォンやタブレットの大部分もARMプロセッサを採用しています。

スマートフォンやタブレットへの応用

モバイルデバイス市場の拡大に伴い、CPU設計者たちは、性能を維持しながらもデバイスのバッテリー寿命を延ばすための工夫を重ねてきました。例えば、ARMはその設計において、省電力モードや効率的なコア設計を導入し、必要な時にだけ高いパフォーマンスを発揮できるようにしています。また、最近のプロセッサではビッグリトル構成(big.LITTLE)という手法が採用されており、パフォーマンス重視の高性能コア(bigコア)と、低電力消費の低性能コア(LITTLEコア)を組み合わせて、処理内容に応じて使い分けることができるようになっています。

これにより、スマートフォンやタブレットは、軽い処理では低電力で動作し、ゲームや動画編集といった高負荷なタスクでは強力なパフォーマンスを発揮することが可能となっています。この技術革新により、モバイルデバイスの性能が飛躍的に向上し、現代の多くのユーザーがデスクトップやラップトップに匹敵するパフォーマンスを手のひらサイズのデバイスで享受できるようになりました。

未来のCPU技術

人工知能とCPUの統合

近年のコンピュータ技術の急速な進化の中で、特に注目を集めているのが人工知能(AI)とCPUの統合です。従来、CPUは一般的な処理を行うための汎用プロセッサとして設計されてきましたが、AIや機械学習に必要な膨大な計算処理には専用のプロセッサが必要となってきました。ここで、特に重要な役割を果たしているのが、GPU(グラフィックス・プロセッシング・ユニット)やTPU(Tensor Processing Unit)といった、AIに特化したプロセッサです。

しかし、将来的にはこれらのAI専用プロセッサと従来のCPUが一体となった設計が求められると考えられています。例えば、IntelはAI推論に特化した命令セットを備えたXeonプロセッサを発表し、これによってCPU単体でもある程度のAI処理が可能となっています。また、AMDやNVIDIAも、AI向けの最適化を進めた新しい世代のプロセッサを開発中です。

これにより、AIの複雑な処理が、より多くのデバイスやシステムで手軽に実行できるようになるでしょう。AIの進化は、今後さらに高速化するCPU技術と相まって、新しい産業やサービスを創出すると期待されています。

量子コンピュータとニューロモルフィック・コンピューティング

現在、従来の半導体技術とは異なるアーキテクチャとして注目されているのが量子コンピュータとニューロモルフィック・コンピューティングです。量子コンピュータは、従来のビットではなく、量子ビット(Qubit)を使用して、複数の状態を同時に扱うことができるという特徴を持ち、非常に高い並列処理能力を持っています。

量子コンピュータは、現代のCPUが得意とする並列計算では対応しきれない複雑な問題(例えば、暗号解読や化学シミュレーションなど)を解くために、次世代のコンピューティング技術として大きな注目を集めています。現時点ではまだ研究段階にありますが、将来的にはCPU技術を補完する形で産業界に革命をもたらす可能性があります。

ニューロモルフィック・コンピューティングは、人間の脳を模倣した計算モデルに基づく技術で、特にエネルギー効率と学習能力に優れています。ニューロモルフィックチップは、従来のデジタルコンピュータが処理に多くのステップを要する認知タスクを、より少ないエネルギーで高速に処理することが可能です。この技術が進化すれば、AIや自律型システムのパフォーマンスが飛躍的に向上するでしょう。

次世代プロセッサに求められる性能

今後のCPU技術には、さらなる高性能化が求められる一方で、以下の3つの要件が特に重要視されると予測されています。

エネルギー効率の向上

従来のシリコンベースのプロセッサは、消費電力と発熱の問題が常に課題となってきました。これを解決するため、より省電力な設計や、新しい材料を用いたプロセッサが求められます。カーボンナノチューブやグラフェンを用いた次世代トランジスタは、エネルギー効率の向上に寄与する可能性があるとされています。

セキュリティの強化

サイバーセキュリティの重要性が増す中で、CPU自体が持つセキュリティ機能もますます重要になります。今後のCPUでは、ハードウェアレベルでのセキュリティ機能の強化が求められ、データ保護や不正アクセスの防止において、より強固な技術が搭載されることが予想されます。

特定用途向けのカスタマイズ

クラウドコンピューティングやエッジコンピューティングが普及する中で、特定の用途や環境に最適化されたカスタムCPUの需要が高まっています。例えば、データセンター向けの超並列処理に最適化されたプロセッサや、IoTデバイス向けの超省電力なプロセッサが今後ますます重要な役割を果たすと考えられます。

まとめ

CPUの進化は、コンピュータの性能向上に大きな影響を与えてきました。RISCとCISCの競争、メガヘルツ戦争を経て、現代のマルチコアプロセッサが誕生し、モバイルデバイスの普及によって省電力化が加速しました。今後は、AIとの統合や量子コンピュータの登場により、さらなる飛躍が期待されています。CPU技術は、私たちの生活や産業を変革する鍵を握っており、今後もその進化は続くでしょう。

コメント